经典卷积网络模型

LeNet(1998)

LeNet-5是由Yann LeCun等人于1998年提出的一种开创性的7层卷积神经网络,旨在进行手写数字的分类。这一网络结构已经被多家银行广泛应用于支票上手写数字的识别,支票通常以32x32像素的灰度图像数字化呈现。然而,LeNet-5的设计是基于当时的计算资源可用性,因此它适用于较低分辨率的图像。对于处理更高分辨率的图像,通常需要更大、更深的卷积神经网络,但这受到计算资源的限制。

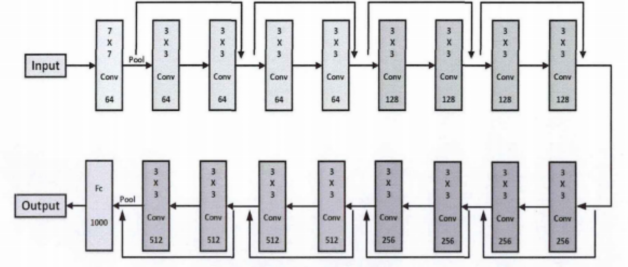

图1:

Yann LeCun是深度学习和神经网络领域的领军人物之一,他的工作对于计算机视觉、自然语言处理和机器学习等领域的发展产生了深远影响,对于推动人工智能技术的发展和应用做出了巨大的贡献。

Yann LeCun是一位杰出的法国计算机科学家,被誉为深度学习和神经网络领域的重要先驱之一。他的研究和贡献在计算机视觉、模式识别和人工智能领域具有深远影响。LeCun博士在学术界和工业界都有卓越的成就。

他曾在纽约大学(NYU)担任教授,并且在纽约大学计算机科学与数据科学中心工作。此外,他还曾在AT&T实验室工作,并在Facebook担任人工智能研究实验室(FAIR)的首席科学家。

LeCun博士的研究集中在神经网络和深度学习领域,特别是卷积神经网络(CNN)。他的CNN模型在计算机视觉任务中取得了卓越的成果,如图像分类、目标检测和语义分割。他还是反向传播算法的早期研究者之一,这一算法在神经网络训练中起着关键作用。

LeCun博士的工作获得了众多奖项和荣誉,包括图灵奖(ACM A.M.图灵奖)等。他的研究对于推动人工智能和深度学习的发展产生了深远的影响,使得计算机能够更好地理解和处理复杂的数据和任务。他的学术贡献和领导地位使他成为人工智能领域的杰出人物之一。

AlexNet(2012年)

在2012年,Alex Krizhevsky等人在ImageNet图像分类大赛中,提出了一种名为AlexNet的神经网络模型,该模型在当年获得了冠军。AlexNet模型在前五个图像分类任务中的准确率达到了84.6%,这一成绩充分展示了神经网络在图像分类领域的卓越性能,同时也推动了深度学习与传统神经网络在图像处理领域的研究应用。

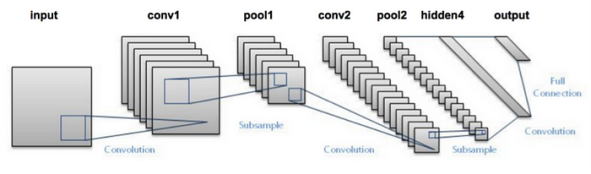

AlexNet模型的核心组成包括五个卷积层和三个全连接层,最后一层是Softmax层。这些层的参数是通过训练得到的。该模型在训练过程中需要使用两个图像处理器,因此大多数参数和输入数据都可以分成两个部分。其网络结构如图2所示。

图2:

在AlexNet模型中,输入图像的尺寸为227x227x3。首先,图像经过具有96个11x11大小和步长2的卷积核的卷积操作,得到一个包含55x55x96个特征的输出图像。然后,通过最大池化层,输出图像的尺寸减半,变为27x27x96。接下来的卷积层使用的卷积核尺寸分别为5x5和3x3,每层之后的特征图尺寸逐渐减小,最终变为6x6x256。

随后,图像经过三个全连接层,分别包含4096个、4096个和1000个神经元。最后一层用于对1000个不同种类的图像进行分类,通过Softmax激活函数后,模型输出1000个单一准确度的数值,表示每个类别的预测概率。

关于有些文中提到的AlexNet输入尺寸为224×224×3。关于输入图像的大小维基百科wikipedia是这样说的:

(AlexNet 图像大小应该是 227×227×3,而不是224×224×3,所以数学结果是正确的。原论文说的是不同的数字,但 Andrej Tesla 计算机视觉前负责人 Karpathy 表示应该是 227×227×3(他说 Alex 没有描述为什么他放 224×224×3)。下一个卷积应该是 11×11,步长为 4: 55×55×96(而不是 54×54×96)。例如,计算公式为:[(输入宽度 227 - 内核宽度 11) / 步幅 4] + 1 = [(227 - 11) / 4 ] + 1 = 55。由于内核输出的长度和宽度相同,因此其面积为55×55。)

AlexNet模型的主要创新点包括:

- 使用ReLU(Rectified Linear Unit)激活函数,有效减轻了深度网络模型在训练时容易出现的梯度消失问题。

- 引入了相互通信的机制,提高了模型的训练速度。

- 引入了局部响应归一化层(LRN),用于增强模型的学习能力和泛化能力,通过对神经元激活值的归一化来实现。

- 提出了局部区域剪裁和Dropout技术,以缓解过拟合问题。局部区域剪裁通过裁剪输入图像的局部区域来增加数据多样性,而Dropout技术随机忽略某些数据以减少参数数量,进一步减小过拟合的风险。

VGGNet(2014年)

在2014年,Karen Simonyan和Andrew Zisserman等人提出了VGGNet,这个模型在当年的ImageNet图像分类竞赛中表现出色。VGGNet采用了四个图形处理器进行并行训练,充分利用了网络的并行性,从而提高了网络性能。在ImageNet图像分类竞赛中,VGGNet的错误率降至了7.3%,Top-5的准确率达到了92.7%,取得了当年的亚军地位。

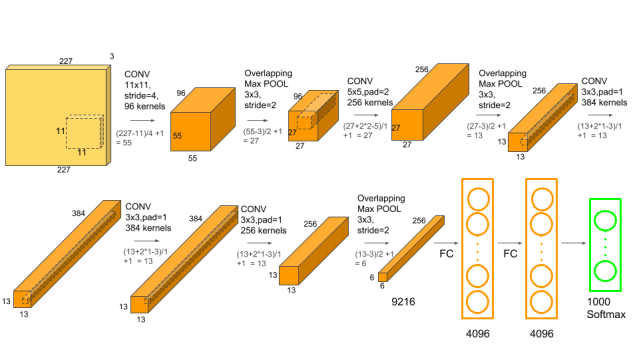

VGGNet可以被看作是AlexNet的更深层次版本,虽然层数更多,但结构更为简单。它使用了多个3x3大小的小卷积核来替代一个7x7大小的大卷积核,同时步长都为2。这种模型设计验证了通过增加卷积层数,加深模型深度能够有效提高模型的识别精度。VGGNet有16层和19层两种不同的模型结构,其中后三层的结构相同,但前面卷积层的数量不同。图3 展示了VGG16模型的网络架构。

在VGG16的结构中,输入图像的尺寸为224x224x3。经过第一个卷积层(3x3x64的卷积核),特征图的尺寸从224x224x3变为112x112x64。接着,通过2x2的最大池化层,输出特征图的尺寸减半至56x56x64。然后,按照网络架构的顺序,通过剩余的卷积层和池化层,特征图的尺寸逐渐减小,最终变为7x7x512。与AlexNet相似,VGGNet的最后一层模块是全连接层,最后一层通过Softmax输出物体类别的概率。VGGNet通过减少模型参数的同时,提高了网络的深度,从而取得更好的实验准确率。

图3:

VGGNet的主要特点包括:

- 使用多个小卷积核来替代大卷积核,这不仅增强了网络的特征提取能力,还提高了非线性映射的能力。

- 通道数在VGGNet模型中按层次递增。例如,第一层有64个通道,然后每一层的通道数都会翻倍,最多可以达到512层。这种递增的设计有助于提取更多细节信息的特征图。

GoogLeNet(2014年)

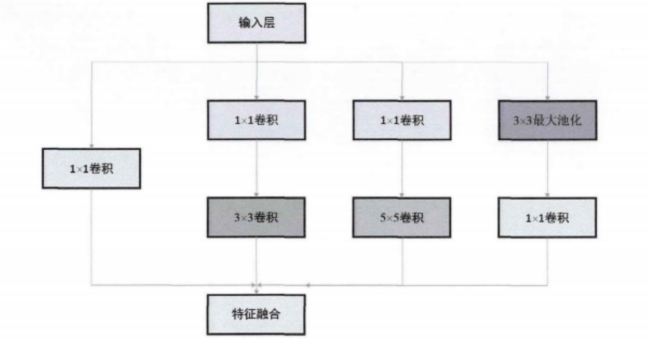

与AlexNet和VGGNet不同,GoogLeNet作为2014年ImageNet大赛的获胜者,其最显著的特点是其网络不仅具有更深的层次,还拥有更广泛的横向”宽度”。GoogLeNet的每一层都具有四条不同的输入处理线,这四条输入处理线分别连接到不同的块,每个块的输出部分都在通道方向上连接在一起。这种并行结构的设计使得GoogLeNet能够在不同的尺度上进行特征提取,更好地适应图像的空间维度变化。

在传统的卷积神经网络中,选择合适的卷积核大小以适应不同的空间分布是一项挑战。对于具有广泛空间分布的图像,需要较大的卷积核,而对于较小空间分布的图像,需要较小的卷积核。为了解决这一问题,GoogLeNet引入了一个名为Inception的输入块,而不是传统的卷积层加激活层的结构。如图4所示,Inception结构允许GoogLeNet并行处理多个卷积核,从而增加了网络的带宽,同时缩小了卷积核的尺寸,提高了网络的效率。这一设计显著减少了网络模型的参数数量。

图4:

ResNet(2015年)

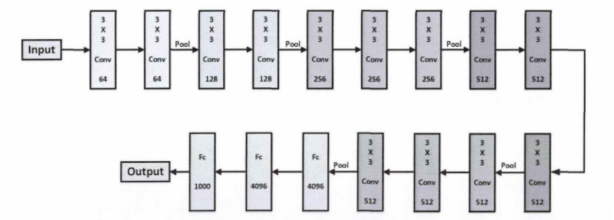

在2015年,何凯明等研究人员引入了ResNet(Residual Network)网络,这一创新标志着卷积神经网络研究领域的又一次重大突破。ResNet网络的最大特点是其极深的结构,可以包含多达152层,这一深度远超过以往的神经网络模型。ResNet在同一年在多个领域取得了显著的成绩,包括目标检测、语义分割和图像识别等领域,实现了历史性的突破,成果令人瞩目。

与传统的神经网络模型相比,ResNet不仅能够实现更好的学习效果,而且具有更少的参数数量。ResNet的出现为研究人员提供了更深层次的训练方法。传统的深度学习方法试图通过逐层叠加卷积层来提取更高级别的特征,但随着网络深度的增加,模型的性能会出现先提高后降低的情况。

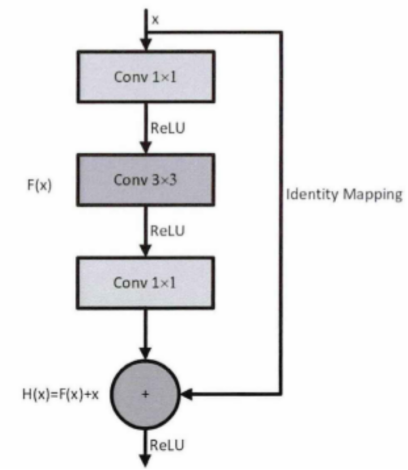

为了解决这个问题,ResNet团队引入了残差网络的概念。残差网络的核心思想是采用”恒等映射连接”(Identity Mapping),即每一层的输出都与前一层相同。这样的设计优势在于减少了数据冗余,更容易进行特征学习,并且残差映射相对于原始映射更容易进行优化。残差块的结构如图5所示。

ResNet的引入不仅允许构建极深层的神经网络,还提供了一种更稳健和高效的训练方法,这对深度学习的发展产生了深远的影响。

图5:

在残差块中,我们假设x是模型的输入,而H(x)是理想的输出。由于引入了”恒等映射连接”,因此H(x)可以表示为H(x) = F(x) + x。在这里,F(x)代表模型真正的学习部分,它是H(x)与输入x之间的差异,即F(x) = H(x) - x。

残差块在某些情况下能够增强网络模型的特征提取,而不会产生副作用。这意味着残差网络能够在减少模型参数的同时提高神经网络的性能。这正是近年来残差网络广泛应用的重要原因之一。

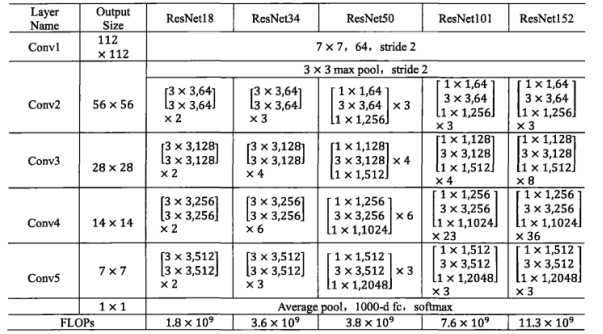

ResNet可以根据其深度划分为不同版本,包括ResNet18(18层)、ResNet34(34层)、ResNet50(50层)、ResNet101(101层)和ResNet152(152层)。每个版本的ResNet具有不同的网络结构参数,这些参数在表2.1中进行了总结。以ResNet18为例,图6展示了ResNet18的网络结构图。

图6:

图7: